| Gefördert durch: | Siemens AG |

| Ansprechpartner am Lehrstuhl: | Andreas Sedlmeier, Thomy Phan, Fabian Ritz, Thomas Gabor |

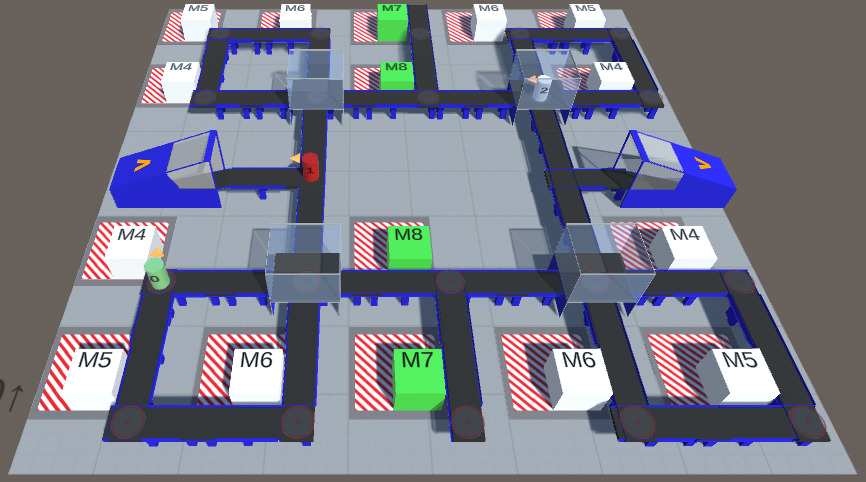

Das Projekt „Zuverlässigkeit von Machine Learning-Verfahren im industriellen Umfeld“ beschäftigt sich mit Fragestellungen zum sicheren Einsatz von aktuellen ML-Verfahren. Neue komplexe Anwendungsszenarien wie autonome Fertigungsanlagen oder die dezentrale Stromerzeugung sind nur noch durch lernende Systeme zu realisieren, deren Verlässlichkeit und Sicherheit jedoch zu jedem Zeitpunkt sichergestellt werden muss. Die Verlässlichkeitsprüfung solcher adaptiven, cyber-physischen Systeme stellt aktuell noch eine große Herausforderung dar. So ergeben sich verschiedene Fragestellungen rund um die Dependability solcher ML-basierter Anwendungen, wie z.B. der korrekte Umgang mit Unsicherheit in den statistischen Vorhersagen, Möglichkeiten zum flexiblen, adaptiven Testen und zur Laufzeitüberwachung der vom System getroffenen Entscheidungen. Ebenso wird es notwendig klassisch definierte Sicherheitsanforderungen in eine für das lernende System verständliche Struktur zu übersetzen. Ziel ist stets, die durch die aktuellen KI-Methoden erzielbare Flexibilität der Systeme vollständig zu nutzen, ohne jedoch Abstriche bei der Sicherstellung der Verlässlichkeit machen zu müssen. Das Projekt wird in Kooperation mit der Siemens AG durchgeführt.

Ausgewählte Publikationen

Ausgewählte Publikationen

- Fabian Ritz, Thomy Phan, Andreas Sedlmeier, Philipp Altmann, Jan Wieghardt, Reiner Schmid, Horst Sauer, Cornel Klein, Claudia Linnhoff-Popien and Thomas Gabor, „Capturing Dependencies within Machine Learning via a Formal Process Model“, in Leveraging Applications of Formal Methods, Verification and Validation. Adaptation and Learning. ISOLA 2022, Lecture Notes in Computer Science, vol 13703, Springer International Publishing, pp.249–265. [DOI][PDF]

- Fabian Ritz, Thomy Phan, Robert Müller, Thomas Gabor, Andreas Sedlmeier, Marc Zeller, Jan Wieghardt, Reiner Schmid, Horst Sauer, Cornel Klein and Claudia Linnhoff-Popien, „Specification Aware Multi-Agent Reinforcement Learning“, in Agents and Artificial Intelligence: ICAART, Lecture Notes in Computer Science, vol 13251, Springer International Publishing, 2022, pp. 3–21. [DOI][PDF]

- Fabian Ritz, Thomy Phan, Robert Müller, Thomas Gabor, Andreas Sedlmeier, Marc Zeller , Jan Wieghardt, Reiner Schmid, Horst Sauer, Cornel Klein and Claudia Linnhoff-Popien, „SAT-MARL: Specification Aware Training in Multi-Agent Reinforcement Learning“, in 13th International Conference on Agents and Artificial Intelligence (ICAART’21), SciTePress, 2021, pp. 28–37. [DOI][PDF]

- Thomy Phan, Thomas Gabor, Andreas Sedlmeier, Fabian Ritz, Bernhard Kempter, Cornel Klein, Horst Sauer, Reiner Schmid, Jan Wieghardt, Marc Zeller, and Claudia Linnhoff-Popien, „Learning and Testing Resilience in Cooperative Multi-Agent Systems“, in 19th Conference on Autonomous Agents and Multiagent Systems (AAMAS ’20), 2020, pp. 1055–1063. [DOI][PDF][video]

- Thomas Gabor, Andreas Sedlmeier, Thomy Phan, Fabian Ritz, Marie Kiermeier, Lenz Belzner, Bernhard Kempter, Cornel Klein, Horst Sauer, Reiner Schmid, Jan Wieghardt, Marc Zeller and Claudia Linnhoff-Popien, „The scenario coevolution paradigm: adaptive quality assurance for adaptive systems“, in International Journal on Software Tools for Technology Transfer (2020) Vol. 22, Springer, 2020, pp. 457–476.[DOI][PDF]

- Thomas Gabor, Marie Kiermeier, Andreas Sedlmeier, Bernhard Kempter, Cornel Klein, Horst Sauer, Reiner Schmid and Jan Wieghardt, „Adapting Quality Assurance to Adaptive Systems: The Scenario Coevolution Paradigm,“ in International Symposium on Leveraging Applications of Formal Methods (ISoLA) (2018)

- Lenz Belzner, Michael Till Beck, Thomas Gabor, Harald Roelle, and Horst Sauer. Software Engineering for Distributed Autonomous Real-Time Systems. In 2nd International Workshop on Software Engineering for Smart Cyber-Physical Systems (SEsCPS@ICSE) (2016)[Download PDF]